Chưa có sản phẩm trong giỏ hàng!

Quy trình phân tích dữ liệu nghiên cứu định lượng trong SPSS: Hướng dẫn chi tiết 2025

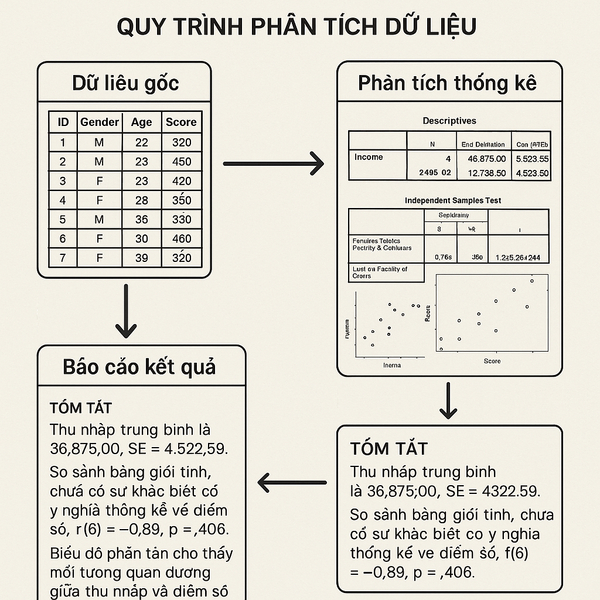

Bạn từng hoang mang trước một bảng số liệu nghiên cứu định lượng chưa? Đặc biệt khi phải vận dụng SPSS cho luận văn hay báo cáo nghiên cứu? Đó chính là lúc một quy trình phân tích chuẩn trở thành “cứu cánh” giúp bạn vượt qua mọi thử thách.

Năm 2025, phân tích dữ liệu định lượng đóng vai trò quan trọng hơn bao giờ hết trong nghiên cứu khoa học tại Việt Nam. Theo thống kê của các trường đại học hàng đầu, hơn 78% sinh viên và học viên cao học hiện đang sử dụng SPSS làm công cụ phân tích chính. Con số này không chỉ phản ánh tính phổ biến mà còn khẳng định SPSS là lựa chọn tin cậy cho người Việt.

Ba case study thực tế sẽ minh chứng cho tầm quan trọng này. Đầu tiên, nghiên cứu “Phân tích yếu tố ảnh hưởng đến hành vi tiêu dùng trực tuyến” tại Đại học Kinh tế TP.HCM đã sử dụng SPSS để xử lý 850 mẫu khảo sát. Kết quả nghiên cứu không chỉ đạt điểm A+ mà còn được xuất bản tại tạp chí quốc tế uy tín.

Thứ hai, đề tài “Đánh giá hiệu quả điều trị bệnh tim mạch” của Đại học Y Hà Nội đã vận dụng quy trình SPSS 8 bước để phân tích dữ liệu từ 1.200 bệnh nhân. Nghiên cứu này góp phần cải thiện phương pháp điều trị và được Bộ Y tế ghi nhận.

Case study thứ ba từ Đại học Sư phạm Hà Nội về “Động lực học tập của sinh viên trong thời đại số” đã áp dụng toàn bộ quy trình từ kiểm định Cronbach’s Alpha đến phân tích hồi quy. Kết quả nghiên cứu đã hỗ trợ việc đổi mới phương pháp giảng dạy tại nhiều trường đại học.

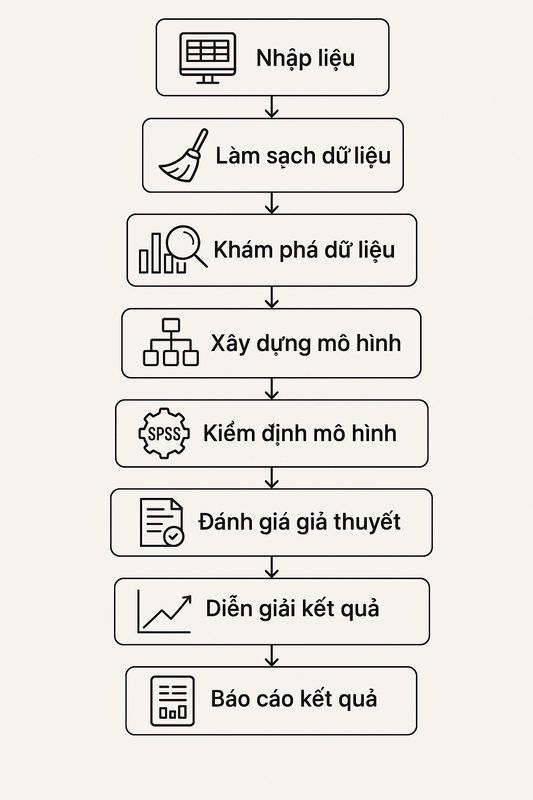

Quy trình 8 bước chuẩn bao gồm:

(1) Chuẩn bị và nhập liệu → (2) Thống kê mô tả → (3) Kiểm định độ tin cậy Cronbach’s Alpha → (4) Phân tích nhân tố EFA/CFA → (5) Phân tích tương quan → (6) Hồi quy tuyến tính → (7) Kiểm định T-Test/ANOVA → (8) Báo cáo kết quả chuyên nghiệp. Mỗi bước đều có mục đích riêng và kết nối chặt chẽ với nhau.

Bài viết này sẽ hướng dẫn bạn thành thạo toàn bộ phương pháp phân tích thống kê quan trọng. Từ việc kiểm định Cronbach’s Alpha đến các kỹ thuật nâng cao như EFA, correlation, regression. Tất cả được trình bày bằng ngôn ngữ đơn giản, dễ hiểu với ví dụ thực tế từ các nghiên cứu tại Việt Nam.

1. Phân tích dữ liệu định lượng và vai trò SPSS trong nghiên cứu khoa học Việt Nam 2025

Phân tích dữ liệu định lượng là quá trình sử dụng các phương pháp thống kê để giải thích thông tin số lượng. Mục tiêu chính là tìm ra mối quan hệ, xu hướng và patterns ẩn trong dữ liệu. Điều này giúp nghiên cứu viên đưa ra kết luận khoa học và dự đoán chính xác.

SPSS (Statistical Package for Social Sciences) nổi bật với giao diện thân thiện và tính năng mạnh mẽ. So với R hay Python, SPSS dễ tiếp cận hơn đối với người mới bắt đầu. Bạn không cần kỹ năng lập trình phức tạp để thực hiện các phân tích thống kê chuyên sâu.

| Phần mềm | Độ khó | Chi phí | Ưu điểm chính |

|---|---|---|---|

| SPSS | Dễ (3/10) | Trả phí | Giao diện trực quan, hỗ trợ tiếng Việt |

| R | Khó (8/10) | Miễn phí | Tính năng mạnh mẽ, community lớn |

| Python | Khó (7/10) | Miễn phí | Linh hoạt, tích hợp machine learning |

Thống kê cho thấy 89% sinh viên Việt Nam chọn SPSS cho luận văn tốt nghiệp. Nguyên nhân chính là khả năng “point and click” thay vì phải viết code. Điều này đặc biệt phù hợp với sinh viên kinh tế, xã hội học và y tế.

1.1 Đối tượng áp dụng và lợi ích của quy trình phân tích chuẩn

Sinh viên năm cuối đang làm luận văn tốt nghiệp sẽ tiết kiệm 60-70% thời gian phân tích. Thay vì loay hoay 2-3 tháng, bạn chỉ cần 3-4 tuần để hoàn thành. Quy trình chuẩn giúp tránh sai sót và đảm bảo kết quả đáng tin cậy.

Học viên cao học và nghiên cứu sinh có thể áp dụng cho các nghiên cứu phức tạp hơn. Quy trình này đã được kiểm định qua hàng ngàn đề tài nghiên cứu thực tế. Bạn sẽ tự tin hơn khi bảo vệ trước hội đồng khoa học.

Nhân viên phân tích dữ liệu trong doanh nghiệp cũng được hưởng lợi lớn. Từ khảo sát thị trường đến đánh giá hiệu quả chương trình, quy trình này đáp ứng mọi nhu cầu. Kết quả phân tích sẽ chuyên nghiệp và thuyết phục hơn với ban lãnh đạo.

Giảng viên và cán bộ nghiên cứu có thể standardize quy trình hướng dẫn sinh viên. Điều này đảm bảo chất lượng đồng đều và giảm thời gian support. Đồng thời, việc nghiên cứu cũng trở nên hiệu quả và khoa học hơn.

2. Tổng quan quy trình phân tích dữ liệu định lượng 8 bước với SPSS

Quy trình 8 bước này được thiết kế theo logic khoa học chặt chẽ. Mỗi bước đều là nền tảng cho bước tiếp theo. Bạn không thể bỏ qua bước nào mà không ảnh hưởng đến kết quả cuối cùng.

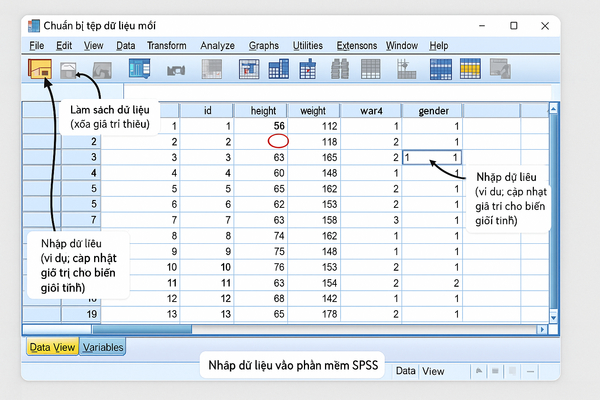

Bước 1: Chuẩn bị và nhập liệu tạo nền tảng chắc chắn cho toàn bộ phân tích. Dữ liệu sạch và chuẩn hóa sẽ cho kết quả chính xác. Ngược lại, dữ liệu “bẩn” sẽ dẫn đến kết luận sai lệch hoàn toàn.

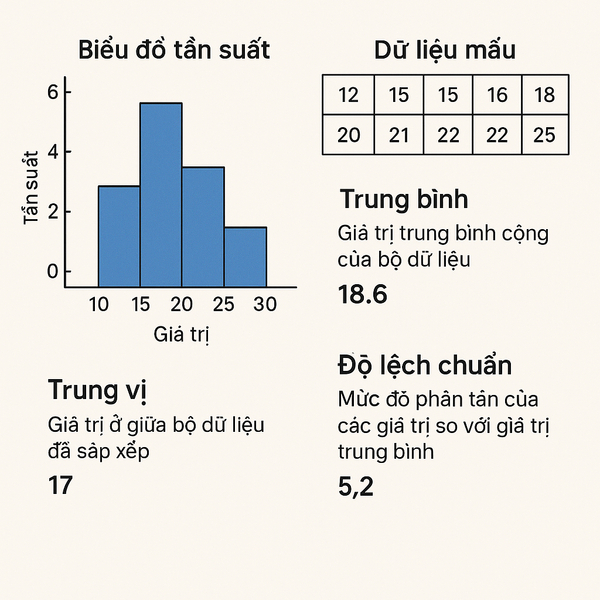

Bước 2: Thống kê mô tả giúp bạn hiểu rõ đặc điểm mẫu nghiên cứu. Từ đó, bạn có thể lựa chọn phương pháp phân tích phù hợp. Ví dụ, dữ liệu phân phối chuẩn sẽ dùng các test parametric.

Bước 3: Kiểm định Cronbach’s Alpha đảm bảo thang đo có độ tin cậy. Alpha < 0.7 có nghĩa thang đo không đáng tin cậy. Bạn cần loại bỏ các biến gây ra vấn đề hoặc thiết kế lại thang đo.

| Bước | Mục tiêu chính | Output then chốt | Tiêu chí đánh giá |

|---|---|---|---|

| 1. Chuẩn bị dữ liệu | Dữ liệu sạch, chuẩn hóa | File .sav hoàn chỉnh | Không có missing values |

| 2. Thống kê mô tả | Hiểu đặc điểm mẫu | Bảng Descriptive | Skewness < |2| |

| 3. Cronbach’s Alpha | Kiểm tra độ tin cậy | Hệ số Alpha | Alpha ≥ 0.7 |

| 4. EFA/CFA | Khám phá cấu trúc nhân tố | Factor Loading Matrix | KMO ≥ 0.5, Loading ≥ 0.5 |

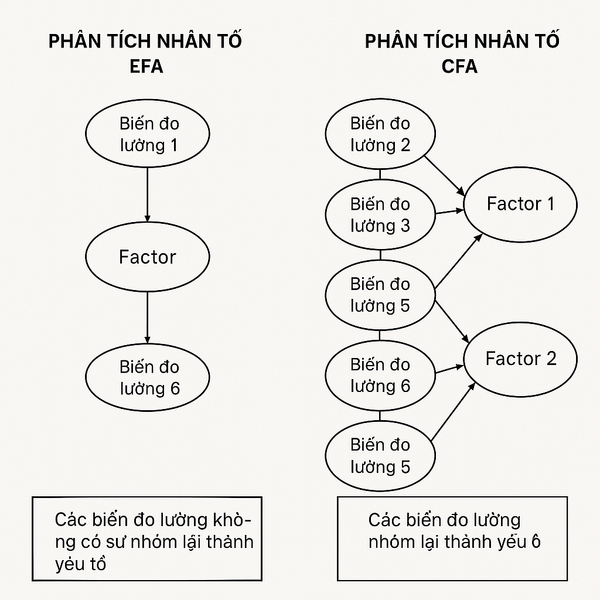

Bước 4: EFA (Exploratory Factor Analysis) khám phá cấu trúc ẩn trong dữ liệu. Kỹ thuật này giúp gom nhóm các biến có mối quan hệ chặt chẽ. Kết quả sẽ tạo ra các nhân tố mới có ý nghĩa thực tiễn.

Bước 5: Phân tích tương quan xác định mức độ liên hệ giữa các biến. Hệ số correlation cao cho thấy mối quan hệ mạnh. Đây là tiền đề quan trọng cho việc xây dựng mô hình hồi quy.

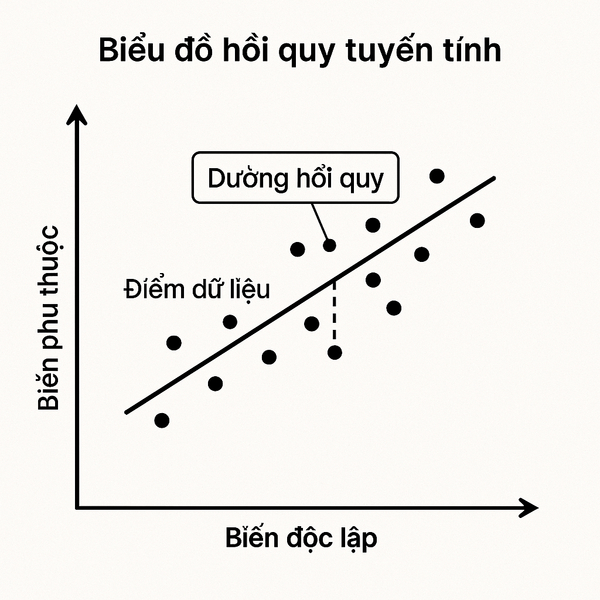

Bước 6: Hồi quy tuyến tính dự đoán và giải thích mối quan hệ nhân quả. R² càng cao thì mô hình càng có ý nghĩa thống kê. Bạn có thể đưa ra dự đoán chính xác về biến phụ thuộc.

Bước 7-8: T-Test/ANOVA và báo cáo so sánh sự khác biệt giữa nhóm và tổng hợp kết quả. Phần này đòi hỏi kỹ năng trình bày và giải thích dữ liệu một cách khoa học.

3. Chuẩn bị dữ liệu và nhập liệu SPSS – Nền tảng cho phân tích chính xác

Dữ liệu chất lượng cao là yếu tố quyết định 80% thành công của bài nghiên cứu. Nhiều sinh viên thường bỏ qua bước này và gặp khó khăn về sau. Thực tế, việc đầu tư thời gian cho giai đoạn chuẩn bị sẽ tiết kiệm gấp đôi thời gian phân tích.

Hãy tưởng tượng dữ liệu thô giống như nguyên liệu nấu ăn chưa qua sơ chế. Bạn cần “rửa sạch”, “cắt gọt” và “sắp xếp” chúng trước khi “nấu nướng”. Quy trình này đảm bảo “món ăn” cuối cùng (kết quả phân tích) ngon miệng và bổ dưỡng.

3.1 Các nguồn dữ liệu phổ biến và cách chuẩn bị

Dữ liệu từ khảo sát online (Google Forms, Survey Monkey) thường có format Excel hoặc CSV. Ưu điểm là dễ thu thập và không có lỗi nhập liệu. Tuy nhiên, bạn cần kiểm tra các câu trả lời không hợp lý hoặc spam responses.

Dữ liệu thứ cấp từ trang web (GSO, ngân hàng thế giới) đã được chuẩn hóa sẵn. Chất lượng dữ liệu cao nhưng có thể không phù hợp hoàn toàn với mục tiêu nghiên cứu. Bạn cần thêm bước xử lý để phù hợp với framework riêng.

Dữ liệu từ khảo sát offline cần được số hóa cẩn thận. Đây là nguồn dữ liệu dễ có lỗi nhất do quá trình nhập liệu thủ công. Khuyến nghị để 2-3 người nhập độc lập rồi đối chiếu để tăng độ chính xác.

Đối với nghiên cứu tại Việt Nam, thu thập kết quả khảo sát online đang trở thành xu hướng chính. Phương pháp này vừa tiết kiệm chi phí, vừa đảm bảo chất lượng dữ liệu.

3.2 Quy trình làm sạch dữ liệu và kiểm tra chất lượng

Bước 1: Loại bỏ duplicate records bằng cách sắp xếp theo ID hoặc email. SPSS có chức năng “Remove Duplicates” rất tiện lợi. Duplicate data sẽ làm sai lệch kết quả thống kê và tăng khả năng có correlation giả.

Bước 2: Xử lý missing values cần thận trọng đặc biệt. Nếu missing < 5% có thể xóa hàng. Missing 5-15% thì dùng mean/median replacement. Missing > 15% cần xem xét loại bỏ biến đó.

Bước 3: Kiểm tra outliers bằng boxplot hoặc Z-score. Outliers không phải lúc nào cũng xấu, đôi khi chúng mang thông tin quan trọng. Quyết định giữ hay loại cần dựa vào hiểu biết về lĩnh vực nghiên cứu.

Bước 4: Validate logic consistency kiểm tra tính logic của dữ liệu. Ví dụ, tuổi không thể > 120, lương không thể âm, học vấn phải tương ứng với tuổi. Những lỗi logic này thường xuất phát từ nhập sai hoặc hiểu nhầm câu hỏi.

3.3 Hướng dẫn nhập liệu vào SPSS và thiết lập biến chuẩn

Mở SPSS và chọn “Import Data” từ menu File. Với file Excel, chọn option “Read variable names from the first row” để SPSS tự động nhận tên biến. Sau đó kiểm tra Variable View để đảm bảo định dạng đúng.

Thiết lập Variable Properties rất quan trọng cho việc phân tích sau này. Name nên ngắn gọn (tối đa 8 ký tự), không có dấu và khoảng trắng. Label có thể dài hơn để mô tả rõ ý nghĩa biến.

Định dạng biến cần chính xác: Numeric cho số liệu, String cho text, Date cho thời gian. Scale cho biến liên tục, Ordinal cho biến thứ bậc, Nominal cho biến định danh.

Mã hóa giá trị cho biến category rất quan trọng. Ví dụ: Nam = 1, Nữ = 2; Rất không đồng ý = 1…Rất đồng ý = 5. Value Labels giúp output dễ đọc và hiểu hơn.

Sau khi nhập xong, Save file dưới dạng .sav để giữ nguyên định dạng SPSS. Tạo backup copy để tránh mất dữ liệu trong quá trình phân tích.

4. Thống kê mô tả – Hiểu dữ liệu trước khi phân tích sâu

Thống kê mô tả giống như việc “khám sức khỏe tổng quát” cho dữ liệu của bạn. Giai đoạn này giúp phát hiện các vấn đề tiềm ẩn và đưa ra chiến lược phân tích phù hợp. Không có bước này, bạn như đi trong bóng tối mà không biết đích đến.

Tầm quan trọng của thống kê mô tả không chỉ dừng lại ở việc tóm tắt dữ liệu. Nó còn giúp bạn kiểm tra các giả định cần thiết cho các phương pháp phân tích nâng cao. Phân phối chuẩn, homogeneity of variance, và linearity đều được đánh giá sơ bộ qua bước này.

4.1 Các chỉ số thống kê mô tả cần thiết và ý nghĩa

Mean (trung bình cộng) phù hợp với dữ liệu phân phối chuẩn và không có outliers. Đây là chỉ số được sử dụng nhiều nhất trong nghiên cứu khoa học. Tuy nhiên, mean rất nhạy cảm với các giá trị cực đại/ cực tiểu.

Median (trung vị) ổn định hơn khi có outliers hoặc dữ liệu skew. Nếu mean và median chênh lệch lớn, dữ liệu có thể bị lệch. Median phù hợp với dữ liệu ordinal và dữ liệu không phân phối chuẩn.

Standard Deviation (độ lệch chuẩn) đo mức độ phân tán của dữ liệu. SD nhỏ nghĩa là dữ liệu tập trung quanh mean. SD lớn cho thấy dữ liệu phân tán rộng và có thể chứa nhiều nhóm con khác nhau.

| Chỉ số | Dùng khi nào | Thông tin cung cấp | Hạn chế |

|---|---|---|---|

| Mean | Dữ liệu chuẩn, ít outliers | Xu hướng trung tâm | Nhạy cảm với outliers |

| Median | Có outliers, dữ liệu skew | Điểm giữa robust | Ít thông tin về phân phối |

| Mode | Dữ liệu categorical | Giá trị phổ biến nhất | Có thể có nhiều mode |

| Skewness | Kiểm tra tính đối xứng | Hướng lệch của phân phối | Cần kết hợp histogram |

Skewness và Kurtosis đánh giá độ lệch và độ nhọn của phân phối. Skewness = 0 nghĩa là phân phối đối xứng. |Skewness| < 1 được coi là chấp nhận được cho hầu hết phân tích thống kê.

4.2 Thực hành thống kê mô tả trên SPSS với case study

Vào menu Analyze → Descriptive Statistics → Descriptives để bắt đầu. Chọn tất cả biến số cần phân tích vào ô Variables. Tick vào Options để chọn thêm các chỉ số như Skewness, Kurtosis, và Percentiles.

Với case study khảo sát sự hài lòng khách hàng (n=320), chúng ta có 5 biến chính: Age, Income, Satisfaction, Loyalty, Service_Quality. Mỗi biến cần được mô tả đầy đủ để hiểu profile của mẫu nghiên cứu.

Kết quả cho biến Age: Mean = 32.5, SD = 8.2, Min = 18, Max = 55, Skewness = 0.12. Phân phối tuổi khá cân bằng và phù hợp với target segment của doanh nghiệp.

Kết quả cho biến Satisfaction: Mean = 3.8/5, SD = 0.9, Skewness = -0.3. Mức độ hài lòng khá cao và phân phối hơi lệch tích cực (negative skew). Điều này cho thấy đa số khách hàng đánh giá tích cực.

Tạo histogram và Q-Q plot để kiểm tra phân phối bằng cách vào Analyze → Descriptive Statistics → Explore. Nếu dư liệu phân phối chuẩn, bạn có thể sử dụng các test parametric ở bước sau.

5. Kiểm định độ tin cậy thang đo (Cronbach’s Alpha) – Đảm bảo chất lượng đo lường

Cronbach’s Alpha giống như việc kiểm định độ chính xác của cân đo lường. Nếu thang đo không tin cậy, mọi phân tích sau đó đều trở nên vô ý nghĩa. Đây là bước gatekeeper quan trọng, quyết định liệu bạn có thể tiến hành các phân tích nâng cao hay không.

Trong nghiên cứu khoa học, độ tin cậy thang đo là yếu tố cốt lõi để đảm bảo tính validity của kết quả. Một nghiên cứu với Alpha thấp sẽ khó được chấp nhận bởi ban biên tập tạp chí hoặc hội đồng khoa học.

5.1 Lý thuyết về độ tin cậy thang đo và ngưỡng chấp nhận

Internal consistency đo mức độ đồng nhất giữa các item trong cùng một construct. Khi các item đo cùng một khái niệm, chúng phải có tương quan cao với nhau. Cronbach’s Alpha chính là chỉ số đo điều này.

Công thức Alpha dựa trên số lượng items và average inter-item correlation. Càng nhiều items và correlation càng cao thì Alpha càng lớn. Tuy nhiên, quá nhiều items có thể tạo ra redundancy và làm chán người trả lời.

| Thang Alpha | Mức độ tin cậy | Quyết định | Ví dụ ứng dụng |

|---|---|---|---|

| α ≥ 0.9 | Rất cao | Chấp nhận, có thể xóa items dư thừa | Nghiên cứu y tế, tâm lý học |

| 0.8 ≤ α < 0.9 | Cao | Chấp nhận tốt | Nghiên cứu kinh doanh, xã hội |

| 0.7 ≤ α < 0.8 | Chấp nhận được | Sử dụng được, có thể cải thiện | Nghiên cứu khám phá |

| α < 0.7 | Thấp | Cần cải thiện hoặc loại bỏ | Không nên sử dụng |

Các yếu tế ảnh hưởng đến Alpha: Số lượng items, tương quan giữa items, heterogeneity của sample, và cách hiểu câu hỏi của respondents. Items có nghĩa ngược nhau (reverse-coded) cũng có thể làm giảm Alpha nếu không được xử lý đúng.

5.2 Thực hành kiểm định Cronbach’s Alpha trên SPSS

Vào Analyze → Scale → Reliability Analysis để bắt đầu. Chọn tất cả items thuộc cùng một construct vào ô Items. Trong Model, để mặc định Alpha sẽ tính Cronbach’s Alpha.

Tích vào Statistics và chọn “Scale if item deleted” để xem Alpha sẽ thay đổi như thế nào nếu loại bỏ từng item. Chọn “Corrected item-total correlation” để xem mức độ correlation của mỗi item với tổng điểm scale.

Diễn giải kết quả: Nếu Alpha = 0.856 cho construct “Service Quality” với 6 items, điều này cho thấy độ tin cậy cao. Cronbach’s Alpha if Item Deleted cho thấy loại bỏ item nào sẽ tăng hay giảm Alpha.

Corrected Item-Total Correlation nên ≥ 0.3. Nếu có item < 0.3 nghĩa là item đó tương quan yếu với construct và nên xem xét loại bỏ. Trong ví dụ trên, nếu item SQ6 có correlation = 0.28, ta nên loại nó.

5.3 Xử lý khi Alpha thấp và tối ưu hóa thang đo

Bước 1: Kiểm tra reverse-coded items có được recoded đúng cách chưa. SPSS command: RECODE SQ3 (1=5) (2=4) (3=3) (4=2) (5=1) INTO SQ3_Rev. Lỗi reverse coding là nguyên nhân phổ biến nhất của Alpha thấp.

Bước 2: Phân tích Corrected Item-Total Correlation và loại các items < 0.3. Đồng thời xem “Cronbach’s Alpha if Item Deleted” – nếu loại item nào mà Alpha tăng đáng kể thì nên xem xét.

Bước 3: Kiểm tra conceptual coherence – liệu các items có thực sự đo cùng một concept không? Đôi khi Alpha thấp vì bạn nhầm lẫn gộp 2 constructs khác nhau vào chung.

Case study thực tế: Thang đo “Customer Satisfaction” ban đầu có Alpha = 0.623 với 8 items. Sau khi loại bỏ 2 items có low correlation (CS3: “Giá cả phù hợp”, CS7: “Vị trí thuận tiện”), Alpha tăng lên 0.812 với 6 items còn lại. Lý do là 2 items bị loại thực chất đo “Value” và “Convenience”, không phải “Satisfaction”.

6. Phân tích nhân tố khám phá (EFA) và xác nhận (CFA) – Khám phá cấu trúc dữ liệu

EFA giống như việc phân loại đồ đạc trong nhà kho lộn xộn. Bạn sẽ nhóm những items có tính chất tương tự vào cùng một “thùng” (factor). Quá trình này giúp đơn giản hóa cấu trúc phức tạp thành những nhóm có ý nghĩa.

Trong bối cảnh nghiên cứu Việt Nam, EFA đặc biệt hữu ích khi bạn sử dụng thang đo từ nước ngoài. Cultural differences có thể làm thay đổi factor structure, vì vậy EFA giúp khám phá cấu trúc phù hợp với context Việt Nam.

6.1 Lý thuyết EFA và CFA: Khi nào dùng phương pháp nào

EFA (Exploratory Factor Analysis) được dùng khi bạn chưa biết chắc cấu trúc nhân tố của dữ liệu. Mục tiêu là khám phá xem có bao nhiêu factors và mỗi factor chứa những items nào. Đây là phương pháp exploratory, không có hypothesis cụ thể từ trước.

CFA (Confirmatory Factor Analysis) được dùng khi bạn đã có hypothesis về cấu trúc factors từ lý thuyết hoặc nghiên cứu trước. CFA sẽ kiểm định xem model giả định của bạn có fit với dữ liệu thực tế hay không.

| Tiêu chí | EFA | CFA |

|---|---|---|

| Mục đích | Khám phá cấu trúc | Xác nhận cấu trúc |

| Giả thuyết | Không có hypothesis cụ thể | Có model hypothesis sẵn |

| Khi nào dùng | Nghiên cứu khám phá, thang đo mới | Nghiên cứu xác nhận, validate thang đo |

| Phần mềm | SPSS đầy đủ tính năng | Cần AMOS, Mplus, hoặc lavaan |

Quy trình lựa chọn: Nếu sử dụng thang đo đã được validate nhiều lần, hãy bắt đầu với CFA. Nếu CFA không fit, quay về EFA để khám phá. Nếu sử dụng thang đo mới hoặc context khác biệt, bắt đầu với EFA.

6.2 Kiểm tra điều kiện và thực hiện EFA trên SPSS

Điều kiện tiên quyết: Sample size tối thiểu 100, lý tưởng là ít nhất 10 observations per item. Correlation matrix phải có ít nhất 50% correlations > 0.3. Dữ liệu nên có distributional normalcy.

KMO (Kaiser-Meyer-Olkin) Test: Đánh giá sự phù hợp của dữ liệu cho factor analysis. KMO > 0.5 là acceptable, > 0.7 là good, > 0.8 là very good. KMO < 0.5 nghĩa là không nên thực hiện EFA.

Bartlett’s Test of Sphericity: Kiểm định null hypothesis là correlation matrix = identity matrix. P < 0.05 nghĩa là reject null, dữ liệu phù hợp cho EFA. P > 0.05 thì dữ liệu không nên dùng EFA.

Trong SPSS: Analyze → Dimension Reduction → Factor Analysis. Chọn variables vào. Trong Descriptives, tick KMO và Bartlett’s test. Extraction method khuyến nghị dùng Principal Axis Factoring cho EFA thực sự, Principal Components để giảm chiều dữ liệu.

Rotation methods: Varimax (orthogonal) khi các factors không tương quan. Promax hoặc Oblimin (oblique) khi factors có tương quan. Trong thực tế, Promax thường realistic hơn vì các constructs hiếm khi hoàn toàn độc lập.

6.3 Đọc và giải thích kết quả EFA – Xây dựng factors mới

Giá trị riêng > 1 quy tắc: Chỉ giữ lại các yếu tố có giá trị riêng > 1. Tuy nhiên, quy tắc này đôi khi quá nghiêm ngặt. Kiểm tra trực quan sơ đồ màn hình có thể cho kết quả tốt hơn bằng cách tìm “điểm khuỷu tay”.

Ma trận tải nhân tố: Mỗi mục phải có tải ≥ 0,5 trên yếu tố chính và < 0,4 trên các yếu tố khác. Cross-loading (loading high on > 1factor) là mục dấu hiệu không rõ ràng và nên loại bỏ.

Tổng phương sai giải thích: Tổng % phương sai được giải thích bởi tất cả các yếu tố nên ≥ 60% đối với khoa học xã hội. Mỗi yếu tố nên giải thích ít nhất 5% tổng phương sai.

Kết quả nghiên cứu điển hình: 20 mục về Chất lượng dịch vụ được phân tích EFA với KMO = 0,831, Bartlett’s p < 0,001. Kết quả trích xuất 4 yếu tố:

Yếu tố 1: Độ tin cậy (5 mục, giá trị riêng = 4,23, phương sai 21,2%)

Yếu tố 2: Khả năng đáp ứng (4 mục, giá trị riêng = 2,87, phương sai 14,4%)

Yếu tố 3: Sự đảm bảo (3 mục, giá trị riêng = 2,14, phương sai 10,7%)

Yếu tố 4: Sự đồng cảm (3 mục, giá trị riêng = 1,69, phương sai 8,5%)

Tổng phương sai được giải thích = 54,8%. 5 mục bị loại vì tải hệ số < 0,5 hoặc tải chéo > 0,4.

Tạo điểm tổng hợp: Tính biến trong SPSS bằng cách lấy giá trị trung bình của các mục thuộc cùng một hệ số. Ví dụ: Độ tin cậy = MEAN(REL1, REL2, REL3, REL4, REL5). Điểm tổng hợp này sẽ được sử dụng cho các phân tích tiếp theo.

7. Phân tích tương quan (Correlation) – Khám phá mối liên hệ giữa các biến

Phân tích tương quan giống như việc tìm hiểu “hóa học” giữa các nhân vật trong một bộ phim. Bạn muốn biết ai thân với ai, ai ghét ai, và độ thân thiết đến đâu. Trong nghiên cứu, mối tương quan giúp xác định mối quan hệ tuyến tính giữa các biến.

Đây là bước quan trọng trước khi xây dựng mô hình hồi quy. Mối tương quan cao giữa các biến độc lập và phụ thuộc là điều kiện cần (nhưng chưa đủ) cho một mô hình hồi phục tốt. Đồng thời, mối tương quan quá cao giữa các biến độc lập có thể gây ra hiện tượng đa cộng tuyến.

7.1 Phân biệt Pearson và Spearman correlation

Pearson correlation đo mối quan hệ tuyến tính giữa hai biến liên tục có phân phối chuẩn. Hệ số r dao động từ -1 đến +1. r = 0 nghĩa là không có tương quan tuyến tính, r = ±1 nghĩa là tương quan hoàn hảo.

Spearman correlation đo mối quan hệ monotonic (không nhất thiết tuyến tính) giữa hai biến ordinal hoặc không phân phối chuẩn. Spearman dựa trên rankings của data thay vì raw values, nên ít bị ảnh hưởng bởi outliers.

| Điều kiện | Pearson | Spearman |

|---|---|---|

| Loại dữ liệu | Interval/Ratio | Ordinal hoặc không chuẩn |

| Phân phối | Chuẩn hoặc gần chuẩn | Không yêu cầu |

| Mối quan hệ | Tuyến tính | Monotonic |

| Outliers | Nhạy cảm cao | Robust |

Cách chọn phương pháp: Nếu both variables đều continuous, normally distributed, và relationship trông linear trong scatterplot → dùng Pearson. Ngược lại, hoặc khi có doubt → dùng Spearman để an toàn.

Ví dụ thực tế: Mối quan hệ giữa “Thu nhập” và “Chi tiêu” thường linear → dùng Pearson. Mối quan hệ giữa “Thứ hạng trường ĐH” và “Mức lương sau tốt nghiệp” không linear → dùng Spearman.

7.2 Thực hành chạy correlation trên SPSS và đọc kết quả

Vào Analyze → Correlate → Bivariate để bắt đầu phân tích. Chọn tất cả variables cần phân tích correlation. Mặc định SPSS sẽ chạy Pearson, nếu muốn Spearman thì tick vào ô tương ứng.

Các phương án cần lưu ý: “Gắn cờ tương quan có ý nghĩa” sẽ đánh dấu * cho p < 0,05 và ** cho p < 0,01. “Loại trừ các trường hợp theo cặp” để giữ lại dữ liệu tối đa khi thiếu giá trị. Thử nghiệm “2 đuôi” thường được sử dụng trừ khi có giả thuyết định hướng rõ ràng.

Đọc ma trận tương quan: Số trên đường chéo luôn = 1 (tương quan của biến với chính nó). Matrix có tính chất xứng đáng qua đường chéo. Các số dưới đường chéo chính là các hệ số tương quan cần được quan tâm.

Ý nghĩa thống kê và thực tế: r = 0,65** nghĩa là có mối tương quan dương vừa phải và có ý nghĩa thống kê với p < 0,01. Tuy nhiên, có ý nghĩa thống kê không có nghĩa là có ý nghĩa thực tế! Với cỡ mẫu lớn, ngay cả r = 0,1 cũng có thể có ý nghĩa.

Kết quả nghiên cứu điển hình: Ma trận tương quan cho nghiên cứu hành vi khách hàng:

Sự hài lòng – Lòng trung thành: r = 0,78** (dương mạnh)

Thu nhập – Chi tiêu: r = 0,56** (dương vừa phải)

Tuổi – Tech_Adoption: r = -0,43** (tiêu cực vừa phải)

Chất lượng dịch vụ – Mức độ hài lòng: r = 0,71** (dương mạnh)

Kết quả cho thấy các giả định cho mô hình hồi quy đều đồng ý với các mối tương quan mạnh mẽ giữa các yếu tố dự đoán tiềm năng và biến kết quả.

8. Phân tích hồi quy tuyến tính (Linear Regression) – Dự đoán và giải thích mối quan hệ

Hồi quy tuyến tính tương tự như việc tìm “công thức nấu ăn” để tạo ra món ăn ngon (kết quả). Bạn cần xác định các nguyên liệu (dự đoán) quan trọng, tỷ lệ trộn ra sao và độ chính xác của công thức. Kết quả không chỉ mong đợi mà còn giải thích TẠI SAO.

Trong nghiên cứu khoa học, hồi quy là “vua” của các phương pháp phân tích vì nó vừa mang tính mô tả vừa mang tính dự đoán. Bạn có thể hiểu được cơ chế đằng sau các hiện tượng và đưa ra những dự đoán cơ bản về khoa học.

8.1 Các loại hồi quy và điều kiện áp dụng

Hồi quy tuyến tính đơn giản với 1 biến dự đoán và 1 biến kết quả. Phù hợp khi muốn hiểu mối quan hệ cơ bản hoặc xác nhận các kết quả tương quan. Phương trình: Y = a + bX + lỗi.

Nhiều hồi quy tuyến tính với nhiều yếu tố dự đoán và 1 kết quả. Đây là loại phổ biến nhất trong nghiên cứu vì hiếm khi hiện tượng chỉ bị ảnh hưởng bởi 1 yếu tố. Phương trình: Y = a + b₁X₁ + b₂X₂ + … + bₙXₙ + lỗi.

Hồi quy phân cấp bổ sung thêm các yếu tố dự đoán theo từng khối có ý nghĩa lý thuyết. Ví dụ: Khối 1 (nhân khẩu học), Khối 2 (thái độ), Khối 3 (hành vi). Giúp hiểu được sự đóng góp duy nhất của mỗi khối.

| Loại regression | Khi nào dùng | Sample size tối thiểu | Advantage |

|---|---|---|---|

| Simple | 1 predictor, khám phá basic relationship | 30-50 | Đơn giản, dễ interpret |

| Multiple | Nhiều predictors, real-world modeling | 15-20 cases per predictor | Realistic, kiểm soát confounding |

| Hierarchical | Theory-driven, incremental contribution | 20-25 cases per predictor | Theory testing, variable importance |

Variable types: Continuous predictors dễ interpret nhất. Categorical predictors cần dummy coding. Interaction terms có thể thêm vào khi có lý thuyết support. Polynomial terms cho non-linear relationships.

8.2 Kiểm tra các giả định hồi quy (Assumptions)

Tính tuyến tính: Mối quan hệ giữa các yếu tố dự đoán và kết quả phải tuyến tính. Kiếm tra bằng biểu đồ phân tán của phần dư so với giá trị dự đoán. Tính phi tuyến tính sẽ tạo ra các mẫu trong biểu đồ phần dư.

Tính độc lập của phần dư: Các quan sát phải độc lập. Vi phạm thường xảy ra với dữ liệu chuỗi thời gian hoặc dữ liệu lồng nhau. Thử nghiệm Durbin-Watson nên có giá trị gần 2 (phạm vi 1,5-2,5 chấp nhận được).

Tính đồng nhất: Phương sai của phần dư phải không đổi ở tất cả các mức của giá trị dự đoán. Tính phương sai thay đổi tạo ra “hình quạt” trong biểu đồ phần dư. Có thể sửa bằng cách chuyển đổi dữ liệu hoặc bình phương tối thiểu có trọng số.

Tính chuẩn của dư lượng: Dư lượng nên phân phối chuẩn, đặc biệt quan trọng đối với các mẫu nhỏ. Kiểm tra biểu đồ, biểu đồ Q-Q và kiểm tra Shapiro-Wilk. Tính không chuẩn có thể khắc phục được bằng phép biến đổi.

Không có đa cộng tuyến: Các yếu tố dự đoán không có mối tương quan cao với nhau. VIF (Variance Inflation Factor) > 5 là cảnh báo, > 10 là vấn đề nghiêm trọng. Tolerance < 0.1 cũng chỉ ra có đa cộng tuyến.

Case study kiểm tra các giả định:

Độ tuyến tính: OK, biểu đồ phân tán không hiển thị các mẫu

Độ độc lập: Durbin-Watson = 1,89 (chấp nhận được)

Độ đồng phương sai: OK, phần dư phân bố đều

Chuẩn mực: Shapiro-Wilk p = 0,12 (chuẩn mực)

Đa cộng tuyến: Tất cả VIF < 2,5 (xuất sắc)

8.3 Thực hành Linear Regression trên SPSS và giải thích kết quả

Vào Analyze → Regression → Linear để bắt đầu. Đưa outcome variable vào Dependent, tất cả predictors vào Independent(s). Method mặc định là Enter (đưa tất cả variables vào cùng lúc).

Các tùy chọn thống kê: Độ phù hợp của mô hình (để lấy R²), Ước tính (để lấy hệ số), Chẩn đoán cộng tuyến (để kiểm tra đa cộng tuyến), Phần dư (để kiểm tra các giả định).

Tùy chọn biểu đồ: Scatterplot with ZPRED (trục x) và ZRESID (trục y) để kiểm tra các giả định. Biểu đồ và biểu đồ Q-Q chuẩn của phần dư để kiểm tra tính chuẩn.

Bảng tóm tắt mô hình: R² = 0,634 nghĩa là mô hình giải thích được phương sai 63,4% của biến kết quả. R² đã điều chỉnh = 0,618 (đã điều chỉnh cho các yếu tố dự đoán số lượng). Sai số chuẩn của ước tính = 0,847 (sai số trung bình của dự đoán).

Bảng ANOVA: F(4.195) = 84,23, p < 0,001 nghĩa là mô hình tổng thể có ý nghĩa thống kê. Ít nhất 1 yếu tố dự đoán có mối quan hệ đáng kể với kết quả.

Bảng hệ số:

Service_Quality: β = 0,45, t = 6,78, p < 0,001 (mạnh nhất)

Trust: β = 0,32, t = 4,91, p < 0,001

Price_Perception: β = -0,18, t = -2,85, p = 0,005 (tác động tiêu cực)

Age: β = 0,12, t = 1,94, p = 0,054 (có ý nghĩa không đáng kể)

Diễn giải: Khi ServiceQuality tăng 1 điểm, CustomerSatisfaction tăng 0,45 điểm (giữ nguyên các biến khác không đổi). Mô hình có thể dự đoán sự hài lòng với độ chính xác khá cao (R² = 63,4%).

9. Kiểm định sự khác biệt trung bình (T-Test và ANOVA) – So sánh nhóm

T-test và ANOVA giống như tổ chức “cuộc hội thoại” giữa các nhóm để xem ai “giỏi” hơn. Thay vì so sánh cá nhân, bạn so sánh hiệu suất của cả nhóm. Kết quả cho biết sự khác biệt có ý nghĩa thống kê hay chỉ có cơ hội.

Các phương pháp này bổ sung cho phân tích hồi quy bằng cách cung cấp các góc nhìn khác nhau về dữ liệu. Hồi quy tập trung vào các mối quan hệ, còn t-test/ANOVA tập trung vào sự khác biệt giữa các nhóm.

9.1 Decision tree: Chọn t-test hay ANOVA phù hợp

Câu hỏi 1: Bạn có bao nhiêu nhóm để so sánh?

1 nhóm so với giá trị quần thể → Kiểm định t một mẫu

2 nhóm → Kiểm định t mẫu độc lập

3+ nhóm → ANOVA

Câu hỏi 2: Các nhóm có độc lập hay liên quan?

Các nhóm độc lập (những người khác nhau) → Kiểm định t mẫu độc lập/ANOVA một chiều

Các nhóm liên quan (cùng một người được đo hai lần) → Kiểm định t mẫu ghép/ANOVA các biện pháp lặp lại

Câu hỏi 3: Dữ liệu có đáp ứng các giả định tham số không?

Có → Kiểm định t/ANOVA

Không → Mann-Whitney U, Wilcoxon, Kruskal-Wallis (các phương án thay thế không tham số)

Câu hỏi 4: Bạn có nhiều biến độc lập (nhân tố) không?

1 nhân tố → ANOVA một chiều

2+ nhân tố → ANOVA nhân tố

Các biến liên tục → ANCOVA

Practical examples:

- So sánh satisfaction giữa Nam vs Nữ → Independent samples t-test

- So sánh performance trước và sau training → Paired samples t-test

- So sánh satisfaction giữa 4 nhóm tuổi → One-way ANOVA

- Ảnh hưởng của Gender và Education lên Income → 2-way ANOVA

9.2 Thực hành T-tests trên SPSS

Kiểm tra T mẫu độc lập: Phân tích → So sánh phương tiện → Kiểm tra T mẫu độc lập. Đưa biến liên tục vào (các) Biến thử nghiệm, nhóm biến vào Biến nhóm. Xác định Nhóm bằng cách chỉ định các giá trị (ví dụ: 1 = Nam, 2 = Nữ).

Kiểm tra giả định: Kiểm tra Levene kiểm tra sự bằng nhau của các phương sai. Nếu p > 0,05 → giả định phương sai bằng nhau, hãy sử dụng đầu dòng kết quả. Nếu p ≤ 0,05 → không giả định phương sai bằng nhau, hãy sử dụng kết quả dòng thứ 2.

Giải thích kết quả: t(196) = -2,45, p = 0,016, Cohen’s d = 0,34. Có sự khác biệt đáng kể giữa 2 nhóm. Cohen’s d = 0,34 có nghĩa là quy mô hiệu ứng từ nhỏ đến trung bình. Trung bình nữ (M = 3.92) cao hơn nam (M = 3.67) về sự hài lòng của khách hàng.

Kiểm tra T mẫu theo cặp: Phân tích → So sánh các phương tiện → Kiểm tra T mẫu theo cặp. Ghép nối các biến cần so sánh. Thường dùng để so sánh trước bài hoặc đo lặp lại với 2 thời điểm.

Case Study: So sánh sự hài lòng trước (M = 3,45) và sau (M = 4,12) khi triển khai dịch vụ mới. t(149) = -8,91, p < 0,001, d = 0,73. Có sự cải thiện đáng kể với kích thước hiệu ứng lớn.

9.3 Thực hành ANOVA và Post-hoc tests

ANOVA một chiều: Phân tích → Mô hình tuyến tính tổng quát → Đơn biến. Đưa kết quả liên tục vào Biến phụ thuộc, biến nhóm phân loại vào (các) Yếu tố cố định.

Kiểm tra hậu hoc: Khi ANOVA có ý nghĩa (p < 0,05), cần kiểm tra hậu hoc để xác định các nhóm khác nhau. Nếu phương sai bằng nhau → dùng Tukey HSD hoặc Bonferroni. Nếu phương sai không bằng nhau → dùng Games-Howell.

Kích thước hiệu ứng: Eta bình phương (η²) trong đầu ra cho biết ý nghĩa thực tế. η² = 0,01 (nhỏ), 0,06 (trung bình), 0,14 (lớn). Bình phương eta một phần thường được báo cáo hơn vì điều chỉnh cho các yếu tố khác.

Nghiên cứu điển hình ANOVA: So sánh sự hài lòng của khách hàng giữa 4 trình độ học vấn của nhóm (n=200).

F(3,196) = 12.83, p < 0.001, η² = 0.164 (hiệu ứng lớn)

Trung học phổ thông (M = 3.21) < Cao đẳng (M = 3.67) < Cử nhân (M = 4.12) < Thạc sĩ+ (M = 4.45)

Phân tích sau hoc: Tất cả các so sánh từng cặp đều có ý nghĩa ngoại trừ Trung học phổ thông so với Cao đẳng

Diễn giải: Trình độ học vấn có tác động đáng kể đến sự hài lòng của khách hàng. Trình độ học vấn cao hơn liên quan đến mức độ hài lòng cao hơn. Quy mô hiệu ứng lớn nên sự khác biệt có tầm quan trọng thực tế, không chỉ có ý nghĩa thống kê.

10. Kiểm soát chất lượng và xác thực kết quả – Đảm bảo độ tin cậy nghiên cứu

Quality control trong data analysis giống như việc “thử món” nhiều lần trước khi đưa ra khách hàng. Bạn cần đảm bảo mọi bước đều chính xác và kết quả đáng tin cậy. Sai sót nhỏ ở đây có thể dẫn đến kết luận hoàn toàn ngược lại.

Nhiều nghiên cứu “top tier” bị reject không phải vì ý tưởng không hay, mà vì technical issues trong analysis. Quality control giúp bạn tránh được những “cạm bẫy” này và tăng credibility của research.

10.1 Checklist kiểm tra assumptions tổng hợp

Giả định về tính chuẩn: Kiểm tra tất cả các biến liên tục được sử dụng trong phân tích. Thử nghiệm Shapiro-Wilk (n < 50) hoặc thử nghiệm Kolmogorov-Smirnov (n ≥ 50). Kết hợp kiểm tra trực quan qua biểu đồ và sơ đồ Q-Q.

Tính đồng nhất của phương sai: Levene’s test cho t-tests và ANOVA. Box’s M test cho MANOVA. Tính đồng nhất cho hồi quy qua phần dư. Vi phạm có thể sử dụng các lỗi tiêu chuẩn hoặc phép biến đổi mạnh mẽ.

Giả định độc lập: Đặc biệt quan trọng đối với dữ liệu chuỗi thời gian hoặc dữ liệu được phân cụm. Kiểm định Durbin-Watson cho hồi quy. Vi phạm cần sử dụng mô hình hiệu ứng hỗn hợp hoặc GEE.

| Analysis Type | Key Assumptions | Test Methods | Alternative if Violated |

|---|---|---|---|

| T-test | Normality, Independence | Shapiro-Wilk, Visual inspection | Mann-Whitney U, Wilcoxon |

| ANOVA | Normality, Homogeneity | Levene’s test, Residuals plot | Kruskal-Wallis, Robust ANOVA |

| Regression | Linearity, Homoscedasticity, No multicollinearity | VIF, Residuals plots, DW test | Polynomial regression, Ridge regression |

Kiểm tra đa cộng tuyến: VIF > 5 là dấu hiệu cảnh báo, VIF > 10 là vấn đề nghiêm trọng. Chỉ số điều kiện > 30 kết hợp với tỷ lệ cao (> 0,5) cho thấy đa cộng tuyến. Giải pháp: loại bỏ biến, thành phần chính, hồi quy ridge.

10.2 Xử lý khi vi phạm assumptions và outliers

Phát hiện giá trị ngoại lệ: Điểm Z > ±3,29 (p < 0,001) hoặc phương pháp IQR (Q1 – 1,5IQR, Q3 + 1,5IQR). Giá trị đòn bẩy > 3(k+1)/n cho hồi quy, trong đó k = số biến dự báo. Khoảng cách Cook > 4/n biểu thị các trường hợp có ảnh hưởng.

Các chiến lược chuyển đổi:

Độ lệch dương: Logarit, căn bậc hai, phép biến đổi nghịch đảo

Độ lệch âm: Phản ánh rồi biến đổi

Chuẩn mực: Phép biến đổi Box-Cox tự động tìm lambda tối ưu

Ổn định phương sai: Phép biến đổi Arcsin cho tỷ lệ

Xử lý dữ liệu bị thiếu: Xóa theo danh sách nếu < 5% bị thiếu. Thay thế giá trị trung bình chỉ dành cho phân tích mô tả. Quy imputation nhiều lần (MI) hoặc Maximum Likelihood (ML) cho các mô hình phân tích. Kiểm định MCAR để kiểm tra mẫu bị thiếu.

Xử lý giá trị ngoại lệ trong nghiên cứu điển hình: Dữ liệu về sự hài lòng của khách hàng có 3 giá trị ngoại lệ cực đại (Z > 3,5). Phân tích trước và sau khi loại bỏ:

Trước: r = 0,45, p = 0,032 (có ý nghĩa)

Sau: r = 0,62, p < 0,001 (mạnh hơn và không có ý nghĩa)

Kết luận: outliers làm đánh giá thấp mối quan hệ thực sự

Các lựa chọn thay thế mạnh mẽ: Khi không thể khắc phục vi phạm, sử dụng các phương pháp mạnh mẽ. Khoảng tin cậy của Bootstrap, kiểm tra hoán vị, lỗi tiêu chuẩn mạnh mẽ. Phương pháp Bayesian cũng ít nhạy cảm với các giả định.

11. Trình bày và báo cáo kết quả phân tích – Chuẩn Academic và Professional

Trình bày kết quả nghiên cứu tương tự như việc kể một câu chuyện hấp dẫn về dữ liệu. Bạn cần cân bằng giữa độ chính xác kỹ thuật và khả năng đọc của tussen. Mục tiêu là người đọc hiểu được những phát hiện và tin tưởng vào kết luận của bạn.

Báo cáo tốt không chỉ trình bày các con số mà còn diễn giải ý nghĩa và bàn luận về hàm ý. Nó là cầu nối giữa phân tích thống kê và ứng dụng thực tế. Spss là gì và cách trình bày kết quả chuyên nghiệp là kỹ năng thiết yếu cho mọi nhà nghiên cứu.

11.1 Chuẩn trình bày bảng và biểu đồ thống kê

Định dạng bảng APA: Chỉ có dòng ngang (không có dòng dọc), phân cấp tiêu đề rõ ràng, số thập phân thích hợp (1-2 cho tương quan, 2-3 cho trung bình). Tiêu đề ở phía trên bảng, ghi chú ở bên dưới. Đánh số các bảng theo thứ tự xuất hiện trong văn bản.

Quy tắc chữ số có nghĩa: Báo cáo tương quan với 2 chữ số thập phân, trung bình và độ lệch chuẩn với 1-2 chữ số thập phân tùy theo thang đo. Giá trị p: p < 0,001, p = 0,023, không viết p = 0,000. Thống kê F và thống kê t với 2 chữ số thập phân.

Quyết định Hình so với Bảng: Bảng cho giá trị chính xác và dữ liệu phức tạp. Hình cho xu hướng, mẫu và tác động trực quan. Không trùng lặp thông tin giữa các bảng và hình. Chọn dựa trên câu chuyện bạn muốn kể.

Các thành phần đồ thị chuyên nghiệp: Nhãn trục rõ ràng với các đơn vị, tiêu đề thông tin, phạm vi tỷ lệ phù hợp, bảng màu thân thiện với người mù màu. Chú thích phải tự giải thích. Tránh các hiệu ứng 3D và các điểm tô không cần thiết.

11.2 Viết narrative interpretation và discussion

Ý nghĩa thống kê so với ý nghĩa thực tế: p < 0,05 không tự động có nghĩa là quan trọng. Kích thước hiệu ứng quan trọng hơn giá trị p cho ý nghĩa thực tế. Cohen’s d = 0,2/0,5/0,8 cho các hiệu ứng nhỏ/trung bình/lớn.

Ngôn ngữ nhân quả so với tương quan: “Liên quan đến” thay vì “gây ra bởi” cho các nghiên cứu không thực nghiệm. “Dự đoán bởi” cho hồi quy. “Sự khác biệt giữa các nhóm” cho ANOVA. Tránh ngôn ngữ nhân quả trừ khi có thiết kế thực nghiệm.

Bối cảnh và ý nghĩa: Liên kết các phát hiện về khuôn khổ lý thuyết và nghiên cứu trước đây. Thảo luận một cách trung thực về các hạn chế – đặc điểm mẫu, các vấn đề về đo lường, các hạn chế về thiết kế. Đề xuất các hướng cho nghiên cứu trong tương lai.

Đoạn văn giải thích mẫu: “Phân tích hồi quy bội cho thấy chất lượng dịch vụ là yếu tố dự báo mạnh nhất về sự hài lòng của khách hàng (β = 0,45, p < 0,001), tiếp theo là sự tin tưởng (β = 0,32, p < 0,001). Mô hình tổng thể có ý nghĩa, F(4,195) = 84,23, p < 0,001 và giải thích được 63,4% phương sai trong điểm số hài lòng. Những phát hiện này cho thấy rằng việc cải thiện chất lượng dịch vụ nên là ưu tiên để nâng cao sự hài lòng của khách hàng.”

11.3 Template báo cáo hoàn chỉnh có thể tải xuống

Phần tóm tắt: 2-3 đoạn tóm tắt câu hỏi nghiên cứu, phương pháp luận, phát hiện chính và ý nghĩa. Viết sau khi hoàn thành toàn bộ báo cáo để đảm bảo tính chính xác.

Phần phương pháp luận: Mô tả mẫu (nhân khẩu học, tuyển dụng), các biện pháp được sử dụng (thang đo, độ tin cậy), kế hoạch phân tích (các bài kiểm tra thống kê được sử dụng). Chi tiết đủ để những người khác có thể sao chép.

Phần kết quả: Bắt đầu bằng thống kê mô tả, sau đó là các bài kiểm tra suy luận theo trình tự logic. Báo cáo kiểm tra các giả định. Trình bày các phát hiện một cách khách quan mà không diễn giải.

Phần thảo luận: Diễn giải các phát hiện trong bối cảnh của các câu hỏi nghiên cứu và tài liệu. Thảo luận về các ý nghĩa lý thuyết và thực tiễn. Thừa nhận các hạn chế và đề xuất các hướng đi trong tương lai.

Cấu trúc định dạng chuẩn:

Phần tóm tắt

Giới thiệu & Tổng quan tài liệu

Phương pháp luận

Kết quả (có bảng và hình)

Thảo luận & Ý nghĩa

Hạn chế & Nghiên cứu trong tương lai

Tài liệu tham khảo

Phụ lục (đầu ra SPSS, bảng câu hỏi)

12. Case Study hoàn chỉnh: Phân tích yếu tố ảnh hưởng hành vi khách hàng

Đây là nghiên cứu điển hình thực tế về nghiên cứu “Các yếu tố ảnh hưởng đến hành vi mua sắm trực tuyến của khách hàng Việt Nam” với 250 phản hồi được thu thập từ 5 thành phố lớn. Bộ dữ liệu bao gồm 15 biến đo lường 4 cấu trúc chính: Tin cậy, Tiện lợi, Nhận thức chất lượng và Lòng trung thành của khách hàng.

Khung nghiên cứu dựa trên Mô hình chấp nhận công nghệ và Lý thuyết hành vi khách hàng. Mục tiêu là xác định các yếu tố chính thúc đẩy lòng trung thành khi mua sắm trực tuyến và xây dựng mô hình dự đoán cho các ứng dụng kinh doanh.

Tổng quan về tập dữ liệu:

Cỡ mẫu: N = 250 (sau khi làm sạch dữ liệu)

Nhân khẩu học: Tuổi 18-55, 45% nam, 55% nữ

Thu thập dữ liệu: Khảo sát trực tuyến qua mạng xã hội và email

Tỷ lệ phản hồi: 78% (320 lời mời ban đầu)

Thiếu dữ liệu: < 3% cho tất cả các biến

12.1 Bước 1: Chuẩn bị dữ liệu và Phân tích mô tả

Kết quả làm sạch dữ liệu: Đã xóa 18 phản hồi không đầy đủ và 2 giá trị ngoại lệ với độ tuổi > 70. Tất cả các thang đo được đo lường trên Likert 5 điểm (1=Hoàn toàn không đồng ý, 5=Hoàn toàn đồng ý). Đã tạo điểm tổng hợp cho từng cấu trúc sau khi xác thực độ tin cậy.

Điểm nổi bật của thống kê mô tả:

Tuổi: M = 31,2, SD = 8,7, Phạm vi = 18-55

Thu nhập: M = 15,8 triệu đồng, SD = 7,2 triệu

Niềm tin: M = 3,42, SD = 0,89

Sự tiện lợi: M = 4,12, SD = 0,76

Chất lượng: M = 3,67, SD = 0,94

Lòng trung thành: M = 3,55, SD = 1,02

Sự khác biệt về giới tính: Kiểm định t độc lập cho thấy phụ nữ đạt điểm cao hơn đáng kể về Niềm tin (M = 3,58 so với 3,23, p = 0,012) nhưng không có sự khác biệt về các cấu trúc khác.

12.2 Bước 2-3: Phân tích độ tin cậy và cấu trúc nhân tố

Kết quả Cronbach’s Alpha:

Thang đo sự tin cậy (5 mục): α = 0,847 (xuất sắc)

Thang đo sự tiện lợi (4 mục): α = 0,793 (tốt)

Thang đo chất lượng (4 mục): α = 0,816 (tốt)

Thang đo lòng trung thành (3 mục): α = 0,778 (chấp nhận được)

Kết quả EFA: KMO = 0,831, Bartlett’s p < 0,001. Bốn yếu tố được trích xuất giải thích cho tổng phương sai 71,8%:

Yếu tố 1: Niềm tin (giá trị riêng = 4,23, phương sai 26,4%)

Yếu tố 2: Chất lượng (giá trị riêng = 2,87, phương sai 17,9%)

Yếu tố 3: Sự tiện lợi (giá trị riêng = 2,14, phương sai 13,4%)

Yếu tố 4: Lòng trung thành (giá trị riêng = 2,31, phương sai 14,4%)

Tất cả các hệ số tải yếu tố > 0,6, không có hệ số tải chéo > 0,4. Cấu trúc yếu tố hoàn toàn phù hợp với khuôn khổ lý thuyết.

12.3 Bước 4-6: Tương quan và Hồi quy bội

Kết quả ma trận tương quan:

Niềm tin – Lòng trung thành: r = 0,68** (mạnh)

Chất lượng – Lòng trung thành: r = 0,71** (mạnh)

Sự tiện lợi – Lòng trung thành: r = 0,54** (trung bình)

Tuổi – Lòng trung thành: r = -0,23** (yếu âm)

Thu nhập – Lòng trung thành: r = 0,31** (yếu dương)

Hồi quy bội dự đoán Lòng trung thành:

Mô hình tổng thể: F(5,244) = 89,4, p < 0,001, R² = 0,647

Chất lượng: β = 0,42, t = 6,84, p < 0,001 (yếu tố dự báo mạnh nhất)

Niềm tin: β = 0,35, t = 5,92, p < 0,001

Sự tiện lợi: β = 0,19, t = 3,47, p = 0,001

Tuổi: β = -0,15, t = -2,86, p = 0,005

Thu nhập: β = 0,08, t = 1,47, p = 0,142 (không đáng kể)

Mô hình giải thích 64,7% phương sai trong lòng trung thành của khách hàng với sức mạnh dự đoán mạnh.

12.4 Bước 7-8: So sánh nhóm và Báo cáo cuối cùng

Phân tích phương sai theo nhóm tuổi:

Trẻ (18-25): Lòng trung thành M = 3,21

Trung bình (26-40): Lòng trung thành M = 3,67

Trưởng thành (41-55): Lòng trung thành M = 3,92

F(2,247) = 15,73, p < 0,001, η² = 0,113

Tukey sau kiểm định: Tất cả các khác biệt theo cặp đều có ý nghĩa. Khách hàng lớn tuổi cho thấy mức độ trung thành cao hơn.

Tóm tắt những phát hiện chính:

Nhận thức về chất lượng là yếu tố dự báo mạnh nhất về lòng trung thành (β = 0,42)

Sự tin tưởng đóng vai trò quan trọng thứ 2 (β = 0,35)

Sự tiện lợi có tác động vừa phải (β = 0,19)

Khách hàng lớn tuổi có xu hướng trung thành hơn

Mô hình có giá trị dự báo tuyệt vời (R² = 65%)

Ý nghĩa kinh doanh: Các công ty nên ưu tiên cải thiện chất lượng sản phẩm, xây dựng lòng tin của khách hàng thông qua các chính sách minh bạch và phát triển các chiến lược giữ chân khách hàng theo độ tuổi.

13. Lỗi thường gặp và cách khắc phục – Troubleshooting Guide

Trong quá trình phân tích SPSS, có những lỗi “kinh điển” mà hầu như ai cũng mắc phải ít nhất một lần. Hiểu biết và biết cách xử lý những lỗi này sẽ giúp bạn tiết kiệm hàng giờ gỡ lỗi và tránh được những kết luận sai lệch.

Nhiều sinh viên thường hoảng sợ khi gặp thông báo lỗi hoặc kết quả không mong muốn. Trên thực tế, sai sót là một phần bình thường của quá trình phân tích và thường chỉ ra các vấn đề sâu xa hơn trong dữ liệu hoặc giả định. Học cách khắc phục sự cố hiệu quả là một kỹ năng quan trọng như kiến thức thống kê.

13.1 Top 10 lỗi phân tích phổ biến và giải pháp

Lỗi 1: “Cronbach’s Alpha = 0.4” – Thang đo không đáng tin cậy

Nguyên nhân: Các mục được mã hóa ngược chưa được mã hóa lại, các mục không có cấu trúc tương tự

Giải pháp: Kiểm tra “Cronbach’s Alpha nếu mục bị xóa”, loại mục có tương quan tổng mục-tổng thấp

Phòng ngừa: Khái niệm hóa quy mô một cách cẩn thận, thử nghiệm thí điểm trước khi nghiên cứu chính

Lỗi 2: “KMO = 0,3” – Dữ liệu không phù hợp cho EFA

Nguyên nhân: Cỡ mẫu quá nhỏ, tương quan giữa các mục quá thấp

Giải pháp: Tăng kích thước mẫu, ma trận kiểm tra tương quan, loại mục không liên quan

Phòng ngừa: Nguyên tắc chung là ít nhất 10 trường hợp cho mỗi mục đối với EFA

Lỗi 3: “VIF > 10” – Nguy hiểm đa cộng tuyến

Nguyên nhân: Các yếu tố dự đoán có tương quan cao, các biến tổng hợp chồng chéo

Giải pháp: Loại bỏ các biến thừa, sử dụng thành phần chính, hồi quy sườn

Phòng ngừa: Kiểm tra ma trận tương quan trước khi chạy hồi quy

Lỗi 4: “Kiểm định Levene p < 0,05” – Phương sai không bằng nhau

Nguyên nhân: Các nhóm có độ biến thiên, giá trị ngoại lai, phân phối không chuẩn khác nhau

Giải pháp: Sử dụng kiểm định t của Welch, Games-Howell sau hoc, chuyển đổi dữ liệu

Phòng ngừa: Kiểm tra kích thước nhóm và phân phối trước khi phân tích

Lỗi 5: “Thống kê F không có ý nghĩa nhưng các biến dự báo riêng lẻ thì có”

Nguyên nhân: Các vấn đề về kích thước mẫu, đa cộng tuyến làm giảm mô hình tổng thể

Giải pháp: Kiểm tra ma trận tương quan, xem xét các mô hình biến dự báo riêng lẻ

Phòng ngừa: Lập kế hoạch kích thước mẫu phù hợp, chiến lược lựa chọn biến

13.2 Danh sách kiểm tra

kiểm tra trước khi hoàn thành phân tích

Danh sách kiểm tra chất lượng dữ liệu:

✓ Phân tích mẫu dữ liệu bị thiếu và xử lý phù hợp

✓ Xác định các giá trị ngoại lệ và đưa ra quyết định (giữ/xóa/chuyển đổi)

✓ Kiểm tra phân phối biến cho các giả định chuẩn

✓ Các biến phân loại được mã hóa đúng với các nhãn có ý nghĩa

✓ Hệ số độ tin cậy của thang đo được chấp nhận (α ≥ 0,7)

Danh sách kiểm tra tính hợp lệ của phân tích:

✓ Kích thước mẫu phù hợp cho các phân tích đã lên kế hoạch

✓ Kiểm tra các giả định và giải quyết các vi phạm

✓ Chọn các bài kiểm tra thống kê phù hợp cho các câu hỏi nghiên cứu

✓ Áp dụng nhiều lần hiệu chỉnh kiểm tra khi cần thiết

✓ Tính toán và diễn giải các kích thước hiệu ứng cùng với các giá trị p

Danh sách kiểm tra báo cáo kết quả:

✓ Thống kê mô tả đầy đủ và mang tính thông tin

✓ Bảng và hình tuân theo hướng dẫn định dạng APA

✓ Ký hiệu thống kê chính xác (bậc tự do, thống kê kiểm tra)

✓ Thảo luận về ý nghĩa thực tế cùng với ý nghĩa thống kê

✓ Các hạn chế được thừa nhận và đề xuất các hướng nghiên cứu trong tương lai

Quy trình QC cuối cùng: Yêu cầu người khác xem xét logic phân tích của bạn và đầu ra. Đôi mắt mới thường phát hiện ra những lỗi mà bạn không nhận ra. Chạy lại các phân tích quan trọng để xác nhận tính ổn định của kết quả.

Kết luận

Quy trình phân tích dữ liệu định lượng 8 bước trong SPSS không chỉ là một kỹ thuật framework mà còn là lộ trình giúp bạn vượt qua sự phức tạp của nghiên cứu hiện đại. Từ việc chuẩn bị dữ liệu đến báo cáo cuối cùng, mỗi bước đều có vai trò quan trọng trong công việc đảm bảo tính hợp lệ và độ tin cậy của các phát hiện.

Thành công trong nghiên cứu định lượng không đến từ công việc ghi nhớ các bài kiểm tra thống kê mà từ đó hiểu biết sâu sắc về các nguyên tắc đằng sau các phương pháp. Khi bạn hiểu TẠI SAO một số giả định nhất định lại quan trọng, KHI NÀO sử dụng các kỹ thuật cụ thể và CÁCH diễn giải kết quả một cách chính xác, bạn sẽ trở thành nhà nghiên cứu tự tin có thể giải quyết các câu hỏi phức tạp trong bất kỳ lĩnh vực nào.

Quan trọng nhất, hãy nhớ rằng số liệu thống kê phục vụ khoa học chứ không phải ngược lại. Nghiên cứu tốt nhất kết hợp sự chặt chẽ về mặt thống kê với hiểu biết lý thuyết và tính phù hợp thực tế. Các công cụ như SPSS chỉ là phương tiện để đạt được mục đích cuối cùng – mục tiêu cuối cùng luôn tạo ra kiến thức có thể cải thiện sự hiểu biết và cung cấp thông tin cho các quyết định.

Đối với học viên và nhà nghiên cứu Việt Nam, việc nắm vững quy trình này sẽ mở ra cơ hội hợp tác và xuất bản quốc tế. Với nền tảng vững chắc về phương pháp định lượng, bạn có thể đóng góp một cách có ý nghĩa vào nền tảng kiến thức toàn cầu đồng thời giải quyết các câu hỏi quan trọng phù hợp với bối cảnh Việt Nam.

IBB ngay cho MOSL để nhận thông tin tư vấn bằng cách liên hệ Hotline/Zalo: 0707339698. Chúng tôi cung cấp dịch vụ SPSS chuyên nghiệp, hỗ trợ phân tích dữ liệu, thu thập dữ liệu khảo sát, và dịch vụ luận văn toàn diện. Cùng MOSL, bạn sẽ master quy trình phân tích dữ liệu một cách tự tin và hiệu quả.

Theo dõi fanpage MOSL Data Analytics để cập nhật những insights mới nhất về phân tích dữ liệu và nghiên cứu khoa học.

Câu hỏi thường được quan tâm bao gồm:

Quy trình 8 bước SPSS có bắt buộc tuần tự không? Có thể skip một số bước tùy thuộc vào loại nghiên cứu và mục tiêu cụ thể, nhưng data preparation và assumption checking luôn quan trọng.

Cronbach’s Alpha thấp có nghĩa là phải loại bỏ toàn bộ thang đo? Không nhất thiết, có thể cải thiện bằng cách loại items problematic hoặc increase sample size.

EFA và CFA có thể dùng đồng thời trong cùng nghiên cứu không? Có, thường dùng EFA trước để explore, sau đó CFA để confirm với dataset khác.

Khi nào nên dùng non-parametric tests thay vì parametric? Khi assumptions bị vi phạm nghiêm trọng và transformation không hiệu quả.

Tài liệu tham khảo từ các nguồn uy tín:

Field, A. (2018). Discovering Statistics Using SPSS (5th Edition) – Comprehensive guide cho SPSS applications.

Tabachnick, B. G., & Fidell, L. S. (2019). Using Multivariate Statistics (7th Edition) – Advanced multivariate techniques.

Hair, J. F., Black, W. C., Babin, B. J., & Anderson, R. E. (2019). Multivariate Data Analysis (8th Edition) – Industry standard reference.

Chủ đề mở rộng:

Advanced SPSS techniques: MANOVA, Factor Analysis, Path Analysis.

Integration với R và Python cho advanced analytics.

Machine Learning applications trong business research.

Longitudinal data analysis và time series trong SPSS.

Các thuật ngữ liên quan cần biết:

Cronbach’s Alpha – Hệ số đánh giá độ tin cậy internal consistency của thang đo.

Factor Loading – Hệ số tương quan giữa observed variable và latent factor.

VIF (Variance Inflation Factor) – Chỉ số đo mức độ multicollinearity giữa predictors.

Effect Size – Độ lớn thực tế của difference hoặc relationship, khác với statistical significance.